このブログはロリポップレンタルサーバを使用しています。

筆者は、このブログが初めてのブログなのですが、レンタルサーバを借りたのも初めてです。

これからブログを始めようと思っている人向けに、レンタルサーバの必要性や、ロリポップレンタルサーバを使ってきた感想について書いていきます。

筆者はロリポップレンタルサーバしか使ったことがないのですが、できるだけ他レンタルサーバとの差についても説明します。

結論としては、ロリポップお勧めですよ!っていう内容になっています。

ブログをはじめるならレンタルサーバ

ブログサービスとレンタルサーバ

ブログをはじめる際、”サーバをどうするか?”について、まず決めなければいけないです。

大きく分けて、ブログサービスを使うか?自分でレンタルサーバを借りるか?の2通りあります。

ブログサービス

まず、ブログサービスについて説明していきます。

ブログサービスを使う場合、以下のようなサービスがあります。

- Amebaブログ

- FC2ブログ

- 楽天ブログ

- Qiitaブログ

各ブログサービスの特色は以下になります。

Amebaブログ

一度は名前はきいた事がある人も多いかと思います。

日本で最もメジャーなブログサービスかと思います。

有名人も多く登録していますね。

メジャー度からするとナンバーワンですね。

FC2ブログ

運営元はアメリカの会社になります。

主な特徴は、他ブログサービスと比べてデザインの変更自由度が高いところですね。

また、ブログサーブスには珍しく、営利目的(アフィリエイト、アドセンス)でのブログ運営が認めらている点についても特色の一つとなります。

楽天ブログ

楽天ブログは、その名のとおり楽天が運営するブログです。

楽天市場との親和性が高いので、楽天一番の商品の紹介によってアフィリエイトをおこない、楽天スーパーポイントを貯めたりすることができます。

ここまで紹介したブログ以外でも同じですが、各ブログサービスでアカウントを作成さえすれば、すぐにブログを始めることができます。

手軽さでいけば、圧倒的にブログサービスを使った方がブログをはじめるスピードは速いです。

レンタルサーバ

ブログを始めるためのもう一つの方法が、自分でレンタルサーバを借りて、そのレンタルサーバ上にブログを構築する方法です。

レンタルサーバはいろいろありますが、代表的なものは以下になります。

- ロリポップ

- エックスサーバ

- さくらのレンタルサーバ

レンタルサーバを借りてブログを始める場合、”借りたらすぐにブログを開始”という訳にはいかないです。

自分で、ブログ環境を構築する必要があります。

ブログ環境を構築するのに有名なソフトウェアがWordPressです。

よく、“WordPressブログでブログを始める”といった表現をする人がいますが、正式にはニュアンスが違います。

正式には、”レンタルサーバを自分で借りて、自分でWordPressをインストールしてブログを始める。”が正解です。

WordPressをインストールというと、何か難しいような印象がありますが、これは極めて簡単です。

インストールウィザードに沿って進めれば、インストールに失敗することはないでしょう。

なぜ、WordPressがこんなに普及しているかと言いますと、“一番有名だから。”という理由だけです。

日本でもメジャーなので、困った時のトラブルシューティングについても、ネット上に豊富に公開されています。

世界のWebサイトの約40%がWordPressで構築されているみたいですね。

WordPressではなくても、ブログサイトは構築することができます。

WordPressは、ジャンルでいくとCMS(Contents Management System)になります。

CMSでいくと、WordPress以外い以下のようなものがあります。

筆者は、Drupalは使ったことがあります。

まあ、WordPressと似たような構成ではありますが。。。

WordPress以外にもCMSは世の中にあふれていますので、何が何でもWordPressを使わなければいけないという訳ではありません。

しかし、やっぱりメジャーなものを使っておいた方が無難です。

何か問題が発生した場合に、解決策がみつかるスピードが段違いに違うので。

レンタルサーバを使った方がいい理由

ブログを始める理由によりますが、圧倒的にレンタルサーバを自分で借りてブログを始めたほうがいいです。

一番の理由は、“自由度の違い”です。

レンタルサーバは、その名の通り、世界のどこかに(クラウドに)存在しているサーバ領域を借りているという事です。

自分のスペースを確保している訳ですね。

なので、どういった目的でそのサーバを使っても自由ですし、アドセンスやアフィリエイトを使用してお金を稼ぐことも自由です。

しかし、ブログサービスの場合は、そうはいきません。

ブログサービスは、いわば、ブログ運営会社(AmebaやFC2)にブログ記事を載せるスペースを提供してもらっているだけです。

ブログ運営会社のルールに沿ってブログ記事を書かなればいけません。

ブログサービスによっては、アドセンスやアフィリエイトを使ったマネタイズ行為は禁止しているサービスもありますし、いきなり運営会社からアカウントを凍結させられる場合もあります。

また、ブログデザインの点でもレンタルサーバを借りてWordPressで構築した方がよいです。

WordPressでブログを構築する際、テーマというものを選択します。

このテーマは、ブログの基本デザインとなり、無料で様々なテーマが公開されています。

自分で気に入ったテーマを選択することで、デザインを自由に設定することができます。

ブログサービスの場合は、そのブログサービスの基本デザインに沿ってブログ記事を作ることになります。

自由にデザインを変更できないという点でも、ブログサービスをお勧めしない理由です。

結局は、ブログを始める目的によって変わりますね。

一秒でも早くブログを開始したくて、アドセンスやアフィリエイトといったマネタイズは今後もおこなわないということであれば、ブログサービスを使った方がよいでしょう。

しかし、デザインも自分で自由に変更したいし、ゆくゆくはマネタイズしていきたいのであれば、圧倒的にレンタルサーバを借りてブログを始めることをお勧めします。

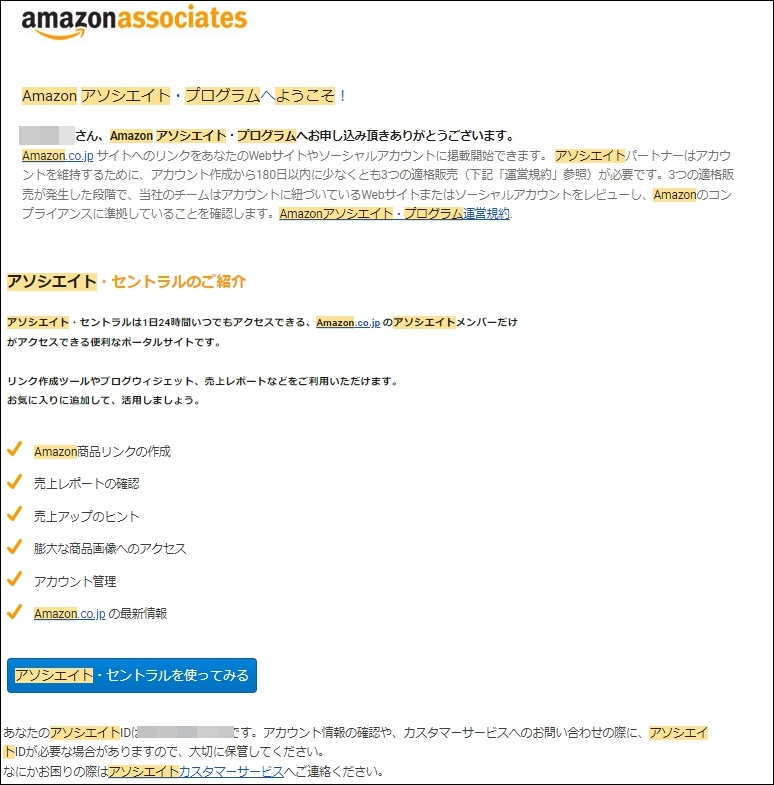

ロリポップを2年使ってきた感想

短刀直入に言うと、ロリポップは初めてブログを使う人にとっては最適、です。

とにかく安い、です。

ロリポップは、用途に合わせて以下の5つのプランがあります。

以下、安い順です。

- エコノミー

- ライト

- スタンダード

- ハイスピード

- エンタープライス

筆者はスタンダードを使っていますが、性能・容量ともに十分です。

何も不都合ありません。

それなのに月額550円ですからね。

正直なところ、始めてブログを作る人は、最初からアクセスが頻繁に発生する訳ではないので、ライトから始めてアクセスが増えてきたらプランをあげていく方式でもいいかと思います。

筆者はいきなりスタンダードから契約したのですが、その理由は、電話サポートの有無です。

電話サポートは、スタンダードプランからしかないので。

でも実際は、2年ロリポップを使っていますが、電話サポートが必要な場面はありませんでした。

なので、今となってはライトから始めてもよかったかなと思っているくらいです。

※エコノミーはWordPressが使えないので、エコノミーから始めるのはやめておいた方がいいですね。

また、ファイルのアップロードやダウンロードをおこなう場合、SSHでの接続が必須だと思いますが、SSHもデフォルトで使えます。

SSHでの接続設定をおこなう必要があるのですが、SSH接続をおこなっても別途領域が発生することはありません。

ドメインを取得する

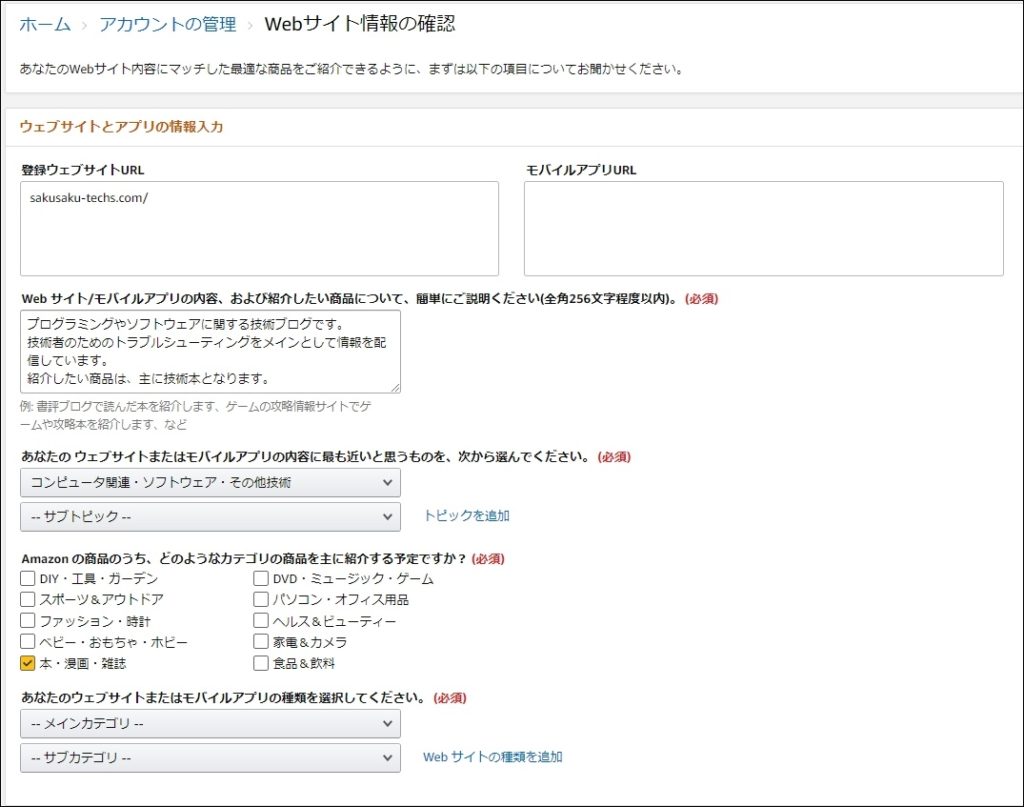

ブログを始めようとした場合は、同時に独自ドメインを取得した方がよいです。

ドメインとは、URLの「http://xyz.com」の「xyz.com」の部分です。

独自ドメインを取得しなかった場合でもブログの公開はおこなうことができますが、ロリポップが提供するデフォルトドメインとなります。

このままでもいいですが、SEO等の観点から、独自ドメインを取得することをお勧めします。

このドメインは、インターネットの世界でユニークなものでなければいけないので、ドメイン提供サービスから使用されていないドメインを検索して取得する必要があります。

お勧めとしてムームドメインです。

ロリポップと同じGMOパペポが運営しているので、ロリポップとの連携がとてもスムーズです。

また、12ヵ月以上契約する場合の限定ですが、ロリポップでレンタルサーバを契約している場合、ムームードメインのドメイン料金は無料です。

ロリポップの料金形態

最後にロリポップの料金形態です。

前述させてもらいましたが、はじめてブログを始める人はスタンダードプランがおすすめです。

ハイスピードは、最初からは不要だと思います。

心配しなくても、そんなにアクセスが集中することはありません。

ブログが育ってきて、契約プランの見直しをおこなう必要があった場合にプランの変更をおこなえばいい、くらいのスタンスでよいかと思います。

個人でブログをおこなう分には、まずエンタープライズは不要です。

|

エコノミー

|

110円

|

|

ライト

|

220円~

|

|

スタンダード

|

550円~

|

|

ハイスピード

|

550円~

※2021/9/11現在 キャンペーン中のようです。

|

|

エンタープライズ

|

2,200円~

|

「~」というのは理由があります。

様々なオプションを付けることができるという感じなんですね。

筆者はバックアップオプションのみ付けています。

月額330円になります。

こういったオプションをつけていくと、上記プランに料金が上乗せされていきます。

筆者は、スタンダードプラン+バックアップオプション付きなので、880円/月になります。

始めてブログを始めるには、お手軽な値段かと思います。